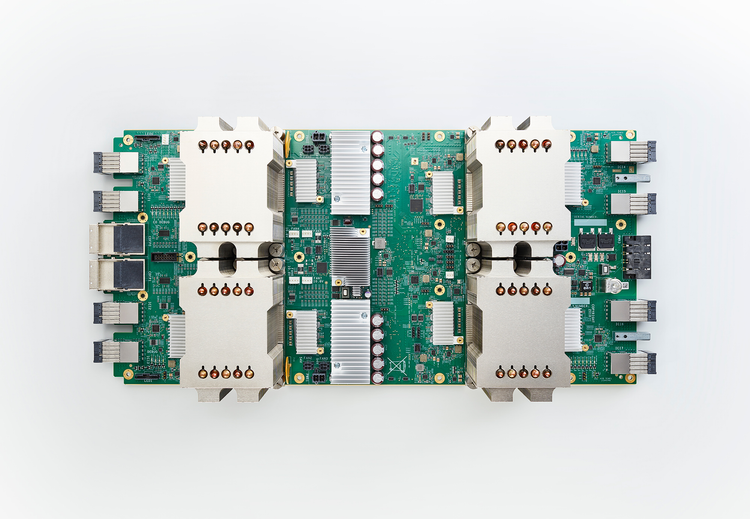

Googles neue "Cloud TPU".

Als Google im Rahmen der I/O 2016 erstmals eigene Prozessoren für Maschinenlernaufgaben vorstellte, sorgte dies für einiges Aufsehen. Ein Jahr später gibt es nun die zweite Hardwaregeneration – und die Möglichkeit sie auch außerhalb von Google selbst zu nutzen.

Training

Die neuen "Cloud TPUs" können nicht nur Maschinenlernaufgaben durchführen, sondern auch gleich die Trainingaufgaben übernehmen, bisher musste dafür auf klassische CPUs und GPUs zurückgegriffen werden. Jede einzelne dieser TPUs soll bis zu 180 Teraflops Fließkommaberechnungen durchführen können. Sie werden aber üblicherweise in einem Verbund als "Pod" aus 64 TPU-Karten genutzt, was 11,5 Petaflops ergeben soll. Das Ergebnis: Trainingszeiten sind um ein Vielfaches schneller als es bisher der Fall war.

Zugriff

Während die erste TPU-Generation nur Google selbst vorbehalten blieb, soll der Nachfolger auch für Kunden des Unternehmens verfügbar sein. TPU-Ressourcen können also künftig über die Google Compute Engine gezielt für Maschinenlernaufgaben eingebunden werden.

Google betont, dass dafür nur minimale Code-Anpassungen gegenüber der Nutzung von CPUs oder GPUs vonnöten ist. Bis es wirklich soweit ist, müssen sich Interessierte aber noch etwas gedulden, Google spricht lediglich vage von "später dieses Jahr" als Termin. (Andreas Proschofsky aus Mountain View, 17.5.2017)