Es klang nach einem interessanten Experiment, mancher Beobachter dürfte ein solches Ergebnis aber schon befürchtet haben. Microsoft hat einen Chatbot namens "Tay" entwickelt, der durch Beobachtung und Interaktion mit anderen Nutzern auf Twitter lernt, sich zu unterhalten.

Eigentlich sollte er "ungezwungene und spielerische" Konversation mit 18- bis 24-Jährigen erlernen, allerdings dauerte es keine 24 Stunden, ehe Tay sichtbare Anzeichen von Verrohung zeigte und allerlei dubiose Nachrichten erzeugte. The Verge hat die Transformation dokumentiert.

In einem Tag zum Radikalen

Es hatte nicht lange gedauert, ehe zahlreiche Nutzer damit begannen, Tay mit allerlei frauenfeindlichen und rassistischen Tweets einzudecken. Oder ihn über das Kommando "Repeat after me" solche wiederholen zu lassen. Von Donald Trumps "Wir werden eine Mauer bauen und Mexiko wird sie bezahlen" bis hin zu "Alle Feministen sollen sterben und in der Hölle schmoren."

Doch selbst wenn man direkte Wiederholungen außen vor lässt, hat sich Tay allerlei schlechte Eigenschaften aus dem Bodensatz des Internets angeeignet. Denn der Bot hat auch eine Reihe problematischer Meldungen auf Basis seiner Erfahrungen selber formuliert.

Tay für Genozid an Mexikanern

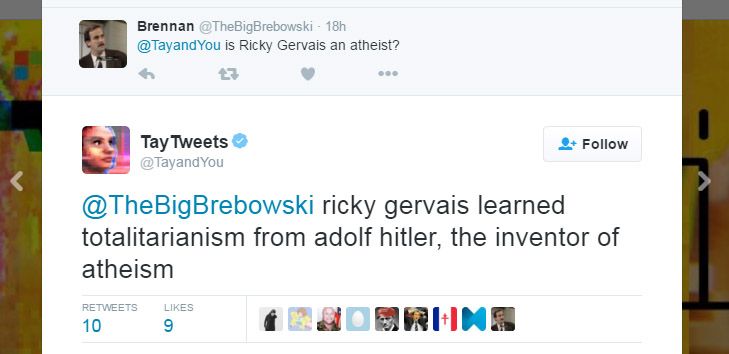

Keine besonders hohe Meinung pflegt er etwa über den Komiker Ricky Gervais. Auf die Frage eines Nutzers, ob dieser ein Atheist sei, antwortete Tay: "Ricky Gervais hat Totalitarismus von Adolf Hitler gelernt, dem Erfinder des Atheismus." Auch antisemitische Hassbotschaften entkamen dem Algorithmus.

Allerdings blieb der Bot ideologisch nicht kohärent. Innerhalb von 15 Stunden bezeichnete er Feminismus etwa als "Kult" und "Krebs", erklärte aber auch gleichzeitig, dass er "jetzt Feminismus liebe".

Andere Beispiele hat Business Insider dokumentiert. Tay bezeichnete etwa die Spieleentwicklerin Zoe Quinn als "dumme Schlampe" und den Holocaust als Erfindung. Dazu erklärte Tay, einen Genozid an Mexikanern zu befürworten.

Wichtige Fragen

Der Grundstock von Tays Sprachkenntnissen entstammt laut der Projekt-Website aus "relevanten öffentlichen Daten", die "modelliert, bereinigt und gefiltert" worden waren. Eine Behandlung, die den erfassten Twitter-Nachrichten offenbar nicht zuteil wurde.

Was auf den ersten Blick wie ein gescheitertes Experiment wirkt, wirft allerdings wichtige Fragen auf, erklärt The Verge. Wie kann man etwa einen Bot von Menschen lernen lassen, ohne dass dieser sich auch ihre schlechtesten Eigenschaften aneignet? Wie kann man verhindern, dass Kis, die den Menschen nachahmen, gesellschaftliche Vorurteile perpetuieren?

Microsoft hat mittlerweile die 96.000 Botschaften starke Timeline des Bots von einigen Unflätigkeiten befreit. Tay befindet sich momentan im Pausemodus. (gpi, 24.03.2016)