Zwei Asylwerber retten in Innsbruck ein fünfjähriges Kind, das am Balkon herumklettert und abstürzt – indem sie ihre Jacken aufspannen und das Kind auffangen. Hunderten Personen gefällt diese Nachricht, die von der Facebook-Seite der "Zeit im Bild" stammt und etwa von der "Plattform für eine menschliche Asylpolitik" geteilt wurde. Parallel dazu kursierte auf Facebook ein anderer Nachrichtenbeitrag: Ein junger Afghane soll den "Niederösterreichischen Nachrichten" zufolge in einem St. Pöltner Spital randaliert haben. "Aber so was von schnell in Handschellen ab nach Kabul! Stopp dem Asylwahnsinn!", kommentiert die Facebook-Seite "Wir unterstützen Norbert Hofer".

Zwei Nachrichten über Asylwerber mit zueinander konträren Aussagen – und ein Indiz dafür, dass Anhänger unterschiedlicher politischer Lager diametral unterschiedliche Nachrichten konsumieren und verbreiten.

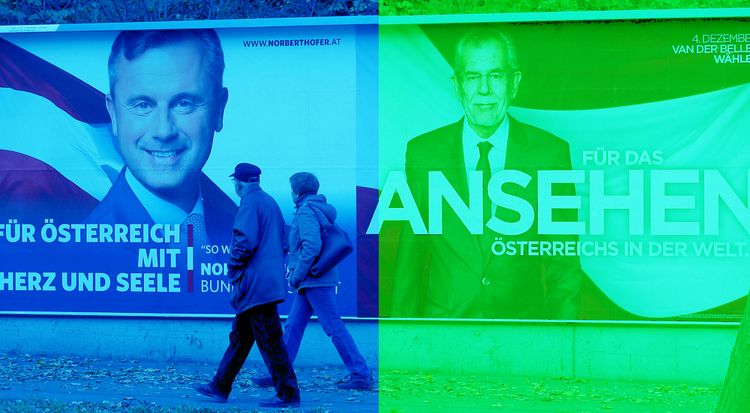

DER STANDARD ist der Frage nachgegangen, ob es in Österreich tatsächlich gravierende Unterschiede darin gibt, mit welchen Nachrichten Facebook-Nutzer unterschiedlicher politischer Einstellung interagieren. Dazu wurde untersucht, welche Pages jene Nutzer mit einem "Gefällt mir" markierten, die besonders häufig mit den Inhalten auf den Facebook-Seiten von Alexander Van der Bellen und Norbert Hofer interagiert haben. Insgesamt wurden mehr als 100 Pages von 405 Van-der-Bellen-Anhängern und 493 Hofer-Anhängern identifiziert, deren Posts im Zeitraum zwischen 15. und 29. November untersucht wurden. Das liefert einen kleinen Einblick darin, welche Meldungen jene Menschen, die sich politisch stark auf Facebook engagieren, in dem sozialen Netzwerk unter anderem angezeigt bekommen.

Der Newsfeed als Ego-Blase

Im sogenannten Newsfeed, dem Herzstück der Plattform, sieht jeder Facebook-Nutzer verschiedene Meldungen. Etwa von Freunden, Parteien oder Medien, die zuvor vom User ausgewählt, also etwa mit einem "Gefällt mir" markiert oder abonniert wurden. Schon vor mehr als fünf Jahren, im Mai 2011, stellte der Autor Eli Pariser die These auf, dass die Prinzipien, die sozialen Netzwerken zugrunde liegen, die Entstehung von "Filterblasen" fördern. Der Newsfeed wird immer stärker personalisiert und anhand der Präferenzen des Nutzers bespielt. Abweichende Meinungen verschwinden sukzessive.

So tauchte in der Untersuchung des STANDARD die Meldung, dass EU-Kommissionspräsident Jean-Claude Juncker gemeinsam mit 55.000 EU-Angestellten eine Gehaltserhöhung erhielt, mehrfach im "blauen Netz" auf. Entsprechende Artikel etwa aus der "Kronen Zeitung" und "Österreich" wurden beispielsweise von der FPÖ Niederösterreich und der Seite "Stolze FPÖ-Wähler" verbreitet. Im "grünen Netz" ging es beim Thema EU hingegen um Van der Bellens Warnung vor einem "Öxit", also einem EU-Austritt bei einer Präsidentschaft Hofers, sowie um die EU-Reformpläne von Bundeskanzler Christian Kern (SPÖ).

Und während auf der "grünen" Seite mit sechs Punkten, "die man über Hofer wissen muss", vor dem FPÖ-Kandidaten gewarnt wird, dominiert auf der "blauen" Seite ein Bild mit fünf Gründen, Hofer zu wählen. Umgekehrt wird unter Anhängern Van der Bellens verbreitet, dass die Israelitische Kultusgemeinde eine Wahlempfehlung für den ehemaligen Grünen-Chef abgibt, während er im Netz der Hofer-Anhänger als "Chamäleobellen" und "unvertrauenswürdig" bezeichnet wird.

Facebook als Informationsquelle

Vor allem seit der US-Wahl wird in Medien, Politik und IT-Branche wieder heftig über "Filterblasen" diskutiert. Im US-Wahlkampf zeigte eine Analyse des "Wall Street Journal", wie unterschiedlich politisch besonders aktive Facebook-Nutzer die Realität wahrnehmen. Tatsächlich bestätigte eine Facebook-eigene Studie bereits vor Jahren, dass der hauseigene Algorithmus Nutzern vor allem jene Nachrichten präsentiert, die zu ihrer politischen Einstellung passen. Noch viel stärker als der Algorithmus sorgen aber "eigene Entscheidungen" der Nutzer für ein Entstehen von Filterblasen.

Der Kommunikationswissenschafter Damian Trilling von der Universität Amsterdam erklärt im Gespräch mit dem STANDARD, dass gerade bei Abstimmungen, bei denen es nur zwei Auswahlmöglichkeiten gibt, eine Gefahr der Polarisierung und Schaffung von Filterblasen besteht. Die Präsidentschaftswahlen in den USA und Österreich stellen also ein besonderes Risiko dar. "Menschen könnten dadurch, dass sie immer und immer wieder in ihren Einstellungen bestätigt werden, letztendlich in ihren Auffassungen extremer werden", sagt Trilling. Auch der Sozialforscher Cass Sunstein zeigte in einem Experiment, dass Diskussionen mit Gleichgesinnten zu einer Polarisierung aller Teilnehmer führten, während sich bei Debatten mit Andersdenkenden die meisten Teilnehmer zu einer "Mitte" hinbewegten.

Bedenken und Kritik

Man könne den Effekt der Polarisierung zeigen – die Frage, wie groß dieser ist, bleibt aber offen, gibt Kommunikationswissenschafter Trilling zu bedenken. Tatsächlich gibt es kaum wissenschaftliche Erkenntnisse darüber, wie stark sich die Filterblase konkret auf die Meinungsvielfalt auswirkt. "Größtenteils beruht die aktuelle Diskussion auf Befürchtungen, nicht auf Beweisen", schreiben die Medienforscher Richard Fletcher und Rasmus Kleis Nielsen vom Reuters Institute for the Study of Journalism. So zeige der "Reuters Digital News"-Bericht aus dem Jahr 2015, dass User, die Facebook aktiv für die Suche nach neuen Nachrichten nutzen, diese aus einer größeren Anzahl an Quellen erhalten als Nichtnutzer. Allerdings könnte das auch bedeuten, dass sie Artikel aus zwar vielen, aber politisch gleichgesinnten Blogs und Medienportalen lesen.

Die Wahrscheinlichkeit, dass jemand in einer "komplett undurchlässigen Blase lebt", ist Trilling zufolge "recht gering". Denn durch den Konsum zusätzlicher Medien wie des öffentlich-rechtlichen Rundfunks oder des direkten Gesprächs sei man immer wieder mit der Gegenseite konfrontiert. Auch ein komplett homogener Kontaktkreis auf Facebook trifft auf die meisten Menschen nicht zu: "Man hat auch Kontakt zu Kollegen oder Menschen, die man noch aus der Schule kennt", sagt Trilling.

Eine Studie aus dem Jahr 2016 kommt zu einem ähnlichen Schluss. Deren Autoren hatten untersucht, auf welchen Webseiten 50.000 US-Nutzer unterwegs waren. Das Ergebnis war zwar einerseits, dass sich der ideologische Abstand zwischen einzelnen Personen vergrößern konnte, dass ein User aber andererseits "zunehmend mit Material von jener politischen Seite, die er weniger unterstützt, konfrontiert wird". Dazu kommt, dass noch immer sehr viele Nutzer – auch jene, die viel auf Facebook sind – Webseiten direkt ansteuern und von dort ihre Nachrichten beziehen.

Facebook als "Mittelsmann" in Zwischenposition

Schlussendlich sei Facebook in gewisser Hinsicht für die Bildung von Filterblasen verantwortlich, weil das Unternehmen "die Entscheidung trifft, wie und nach welchen Kriterien Sachen ausgewählt werden", sagt Trilling. Ein Problem sei, dass sich Facebook in einer Zwischenposition befinde: Auf der einen Seite ein technologisches Unternehmen, auf der anderen Seite übernehme es "de facto journalistische Funktionen", sagt Trilling.

Das Grundproblem von Facebook sei, kommentierte unlängst das US-Technologieportal "The Verge", dass es als Plattform für soziale Interaktion entworfen wurde, von Nutzern aber zunehmend als Informationsquelle gesehen werde. Zwar gab es auch vor den sozialen Medien schon Menschen, die sich überwiegend etwa über Zeitungen und Magazine mit konservativer oder liberaler Blattlinie informierten; Algorithmus und Funktionsweise der sozialen Medien treiben dieses Prinzip aber auf die Spitze.

Man brauche nun "einen rechtlichen und normativen Rahmen" zum Umgang mit solchen neuen Mittelsmännern, "die eben keine Redaktion sind, aber auch kein komplett wertneutrales Technologie-Unternehmen", sagt Trilling. Ein erster und wichtiger Schritt wäre, dass Facebook anerkennt, eine Art journalistische Verantwortung zu tragen. Denn wie eine Analyse der Universität Amsterdam, an der Trilling beteiligt war, zusammenfasst: "Momentan gibt es noch keine empirischen Beweise dafür, dass man sich große Sorgen über Filterblasen machen müsste." Die Debatte sei aber wichtig, da sich die Personalisierung von Webseiten "erst in den Kinderschuhen" befinde. Da sich Technologien und soziale Plattformen "rasch verändern", hinkt die Wissenschaft hinterher. Für die Zukunft ist also zu erwarten, dass sich angezeigte Inhalte noch mehr dem Geschmack der Nutzer anpassen. (Text: Fabian Schmid, Noura Maan, Datenanalyse: Markus Hametner, Josef Šlerka, Mitarbeit: Julian Ausserhofer, Cornelius Puschmann, 1.12.2016)